13. Dezember 2023, 17:42 Uhr | Lesezeit: 10 Minuten

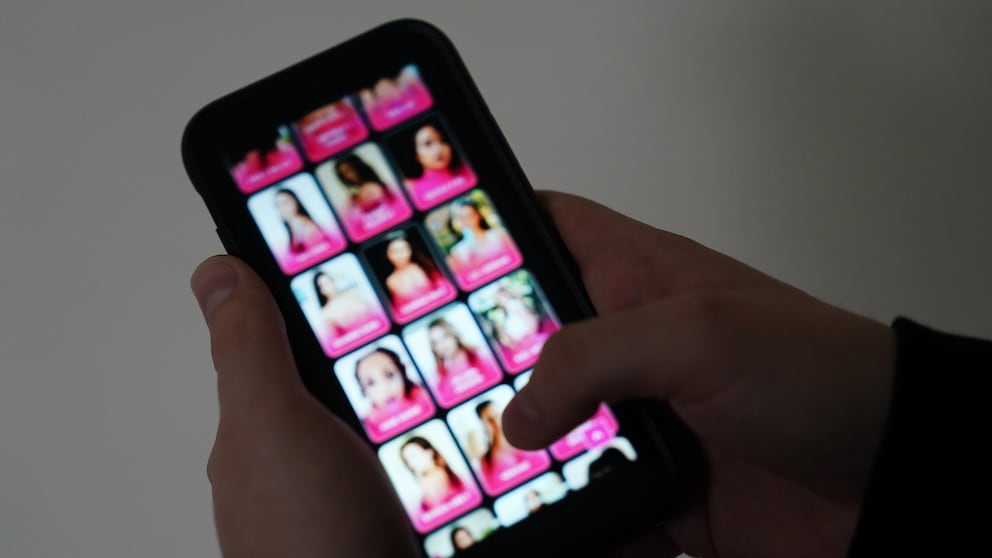

Eigentlich könnte man mit KI großartige Dinge machen – zum Beispiel Gaming-Charaktere in KI-generierten Fotos zum Leben erwecken. Oder Schwimmer vor dem Ertrinken retten. Stattdessen werden „Nudify“-Apps genutzt, um missbräuchliche Nacktbilder von Frauen zu erstellen. TECHBOOK hat mit Medienrechtsanwalt Christian Solmecke über die Rechte von Betroffenen gesprochen.

Es ist ein Übel, mit dem weibliche Stars und Promis schon lange zu kämpfen haben: gefälschte Nacktbilder oder Pornos, in die das Gesicht der Betroffenen hineinmontiert wurde. Statt skurriler Collagen ermöglichen heutzutage KI-basierte „Nudify“-Apps sehr realistische Deepfakes. Aktuelle Zahlen des Analyseunternehmens Graphika zeigen, welches Ausmaß der Missbrauch mit KI-generierten Nacktbildern erreicht hat. Für die betroffenen Opfer bedeuten Deepnudes und Deepfake-Pornografie eine massive Rechtsverletzung mit weitreichenden Folgen. TECHBOOK hat mit dem Medienrechtsanwalt Christian Solmecke über die Rechte der Betroffenen gesprochen.

Übersicht

Steigende Nachfrage nach „Nudify“-Apps

Bereits 2019 hatten Entwickler eine erste KI-basierte App auf den Markt gebracht, die Deepnudes generierte. Deepnudes sind eine Unterform von Deepfakes. Die KI bearbeitet neutrale Fotos so, dass die abgebildete Person nackt oder auch in pornografische Kontexten dargestellt wird. TECHBOOK verzichtet an dieser Stelle auf die Nennung konkreter Apps und Websites, um ihnen keine Plattform zu bieten. 2019 war die App eine eher unbekannte Nischenanwendung mit nur mäßig glaubwürdigen Ergebnissen. Oft sahen die ausgetauschten Gesichter seltsam verzerrt aus oder schimmerten unpassend. Insgesamt waren die Fälschungen relativ gut als solche erkennbar.

Seitdem aber haben sich die technischen Voraussetzungen weiterentwickelt. Mittlerweile gibt es zahlreiche „Nudify“-Apps und -Websites, die täuschend echte Bilder und Videos produzieren. In einem Bericht von Dezember 2023 stellte Graphika aktuelle Zahlen zur Produktion und Verbreitung von „synthetischen, nicht-einvernehmlichen, intimen Bildern“ (auch NCII: synthetic non-consensual intimate imagery) vor. Allein im vergangenen September verzeichneten die 34 untersuchten NCII-Anbieter 24 Millionen Nutzer. Parallel dazu stieg das Volumen von Referral-Link-Spam auf Social Media Plattformen – vor allem Reddit und X – seit Anfang 2023 um 2000 Prozent an. In totalen Zahlen bedeutet das eine Steigerung von 1280 auf 32.100 Verlinkungen. Eine weitere Millionen Nutzer von „Nudify“-Anbietern konnte Graphika in insgesamt 52 Telegram-Gruppen ausfindig machen.

Lesen Sie auch: Suchmaschinen unternehmen kaum etwas gegen gefälschte Promi-Nacktbilder

Aggressive Werbung für „Nudify“-Apps

Dass plötzlich deutlich mehr Menschen – überwiegend Männer – „Nudify“-Apps und NCII-Anbieter nutzen, hängt mit den zunehmend leistungsfähigeren KIs zusammen. Die Ergebnisse wirken immer realistischer. Da die verwendeten Diffusionsmodelle als Open Source frei zugänglich sind, können App-Entwickler sie kostenlos verwenden. Das Erstellen von „Nudify“-Apps ist damit vergleichsweise niedrigschwellig.

Für die Betroffenen, von denen ohne ihre Einwilligung Deepnudes im Internet kursieren, sind „Nudify“-Apps ein Alptraum. Für die Anbieter ist es dagegen ein einträgliches Geschäftsmodell. Dementsprechend aggressiv fällt die Bewerbung aus. Die NCII-Anbieter bewerben ihre Apps und Websites wie etablierte E-Commerce-Unternehmen: durch Anzeigen und Kundenempfehlungsprogramme. Besonders auf Social Media zeigen die Anbieter Präsenz, etwa durch Referral-Link-Spam aber auch durch Kooperationen mit Influencern. In dem Bericht führt Graphika als Werbebeispiel einen Beitrag auf X an, der die Anwendung einer „Nudify“-App als Möglichkeit zur Belästigung präsentiert.

Deepnudes und Videos werden typischerweise über Social Media und in eineschlägigen Foren verbreitet. Gegenüber der Times sagte ein Reddit-Sprecher, dass Reddit die nicht-einvernehmliche Verbreitung von gefälschtem pornografischen Material verbietet. In Folge einer Untersuchung habe Reddit mehrere Domians gesperrt. Großflächig wirksam und kontrollierbar dürfte das Verbot aber nicht sein. TikTok verfolgt laut Golem und Times eine andere Taktik und blockiert die Suche nach Schlagwörtern wie „nudify“ und „undress“. Und auch Meta scheint Suchbegriffe, die im Zusammenhang mit den einschlägigen Diensten stehen, zu beschränken. Die steigenden Nutzerzahlen der „Nudify“-Apps scheinen jedoch eher den Erfolg der NCII-Werbestrategien zu bestätigen.

Vor allem Frauen von Deepfake betroffen

Charakteristisch für Deepfake Pornografie – in Abgrenzung zu anderen Formen von bildbasierter sexualisierter Gewalt – ist die eindeutige Verteilung von männlichen Tätern und weiblichen Betroffenen. Bei einer empirischen Studie 2020 gaben 37,7 Prozent der Befragten in Australien, Neuseeland und Großbritannien an, schon einmal Opfer von bildbasierter sexualisierter Gewalt gewesen zu sein. (Die Dunkelziffer dürfte deutlich größer ausfallen, da Betroffene sich des kursierenden Materials oft nicht bewusst sind.) Doch nur Frauen gaben an, von Deepfakes betroffen zu sein.

„Die Datenlage zur Betroffenheit ist desolat“, sagt Josephine Ballon, Geschäftsführerin von HateAid, gegenüber TECHBOOK. Die gemeinnützige Organisation setzt sich für Menschenrechte im digitalen Raum ein. Erst im Oktober übergab HateAid eine Petition ans Bundesministerium für Verkehr und Digitales, die Maßnahmen zu einem stärkeren Schutz vor Deepfake Pornografie verlangt. Gegenüber TECHBOOK fordert Ballon außerdem: „Hier braucht es dringend Forschung, um Evidenz für das Problem zu schaffen.“

Das Forschungsunternehmen Sensity AI schätzte bereits 2021, dass 90 bis 95 Prozent aller Deepfake-Videos nicht-einvernehmliche Pornos seien. In wiederum 90 Prozent dieser Videos seien Frauen zu sehen. Manche der „Nudify“-Apps funktionieren überhaupt nur bei Fotos von Frauen – so auch jene „Vorreiter“-App von 2019. Die App verschwand übrigens schon bald nach ihrem Erscheinen wieder vom Markt. Die Entwickler entfernten sie allerdings nicht aus moralischen Gründen. Der Andrang war schlicht zu groß.

Lesen Sie auch: KI-generierte Nacktbilder sorgen für Diskussion

Deepfake Pornografie als wachsende Gefahr

Grundsätzlich kann jede Person von Deepfake Pornografie betroffen sein, die Bilder von sich auf Social Media oder auf Websites teilt. Seit der Etablierung von „Nudify“-Apps hat bildbasierte sexualisierte Gewalt in Form von Deepfakes stark zugenommen und wird sich wohl noch weiter verbreiten. Anders als bei gefälschten „Promi-Pornos“ sind vor allem normale Menschen von Deepfake-Pornografie betroffen. Die Verbreitung von gefälschten Nacktbildern, gezielte Belästigungskampagnen und Sextortion (Erpressung mit intimen Bildern) dürften in Zukunft noch stärker zunehmen. Auch kinderpornografisches Material kann leichter und in immer größeren Mengen erstellt werden.

Erst im September erschütterte ein Fall Spanien, bei dem Täter Deepnudes von über 20 Schülerinnen angefertigt und über WhatsApp-Gruppen verbreitet hatten. Die Betroffenen waren zwischen elf und 17 Jahren alt. Im November verurteilte ein Gericht in North Carolina, USA, einen Kinderpsychiater zu 40 Jahren Haft, weil er mit einer „Nudify“-App Nacktbilder von Patienten generierte. Die Reihe lässt sich fortsetzen.

Die britisch-neuseeländisch-australischen Studie von 2021 befragte anonyme Täter nach ihren Motiven, Fotos und Videos ohne Einwilligung der gezeigten Personen zu erstellen oder zu teilen. Rund 60 Prozent nannten Spaß als ihr Hauptmotiv. Circa 38 Prozent wollten Freunde beeindrucken oder mit den Bildern handeln. 45 Prozent gaben, Kontrolle über die betroffene Person ausüben zu wollen, während 38 Prozent die Ex-Partnerin zurückgewinnen oder erniedrigen wollten. Der Missbrauch durch Deepfakes wird also auch in besonderem Maße durch Machtstrukturen geprägt.

Anna Lehrmann, Beraterin im Verein „Frauen helfen Frauen“, sagte gegenüber der Tagesschau: „Ganz viele Frauen sagen auch: ‚Ich will gar nichts dagegen tun, weil ich so große Angst habe, dass es dann dadurch noch schlimmer wird‘.“ TECHBOOK hat mit Medienrechtsanwalt Christian Solmecke darüber gesprochen, welche Rechte und Handlungsmöglichkeiten Betroffene in diesen Fällen haben.

Diese Rechte haben Betroffene

Weder das Erstellen von Deepfakes noch „Nudify“-Apps an sich sind in Deutschland per se illegal. Wer aber von Deepfake-Pornografie betroffen ist, hat grundsätzlich mehrere Ansatzpunkte, um den Täter rechtlich zu belangen.

„Die Frauen, deren Gesichter auf pornografische Fotos montiert werden, werden zunächst in ihrem allgemeinen Persönlichkeitsrecht verletzt und haben hieraus zivilrechtliche Ansprüche gegen den Täter.“, erklärt Medienrechtsanwalt Solmecke. Über den zivilrechtlichen Weg kann man eine einstweilige Verfügung sowie eine Unterlassungsklage erwirken. Außerdem können Betroffene Schadensersatzansprüche geltend machen, da Deepfakes „eine schwere Verletzung der persönlichen Ehre sind und sogar die sog. Intimsphäre betreffen, also den absolut geschützten Kern des Persönlichkeitsrechts.“

Auch strafrechtlich können Betroffene den Täter, sofern bekannt, nach § 42 des Bundesdatenschutzgesetzes belangen: „Hier droht eine Geldstrafe oder Haftstrafe bis zu 2 Jahren, wenn man bei der Datenverarbeitung die „Absicht“ hat, einen anderen zu schädigen. Strafrechtlich können sich Täter außerdem wegen Beleidigung, Verleumdung oder übler Nachrede (§§ 185 – 187 Strafgesetzbuch) strafbar machen.“ Die Maximalstrafe beläuft sich hier auf 5 Jahre Freiheitsstrafe.

Eine explizite Regelung zu Deepfake Pornografie sieht das Gesetz dagegen nicht vor, sodass sich Grauzonen im Rechtsschutz ergeben. Nach § 201a StGB ist es laut Solmecke zwar „verboten, Bildaufnahmen zugänglich zu machen, die geeignet sind, das Ansehen einer Person erheblich zu gefährden“ – was bei echten Nacktaufnahmen zutreffen kann. Doch ob das auch auf Deepfake Pornografie zutrifft, ist durch die Formulierung „Aufnahme“ fraglich. Die weitreichenden Folgen für betroffene Frauen werden jedoch kaum dadurch gemindert, dass die Deepfakes nicht ihren echten Körper zeigen – zumal Deepfakes mittlerweile oft nicht mehr als solche erkennbar sind.

Der Deutsche Juristinnenbund kritisiert den „strafrechtlichen Schutz [von Erwachsenen] vor bildbasierter sexualisierter Gewalt“ als lückenhaft. Betroffene können zwar rechtlich gegen Deepfake Pornografie vorgehen, doch anders als Upskirting oder Downblousing (§ 184k StGB) gibt es keine explizite strafrechtliche Regelung für diesen Sachverhalt. Außerdem greifen die zivil- und strafrechtlichen Instrumente meist zu spät, sodass sich die Inhalte bereits verbreitet haben. Darüber hinaus sind die Täter in der Praxis oft unbekannt und die weiterverbreitenden Plattformen sitzen im Ausland. Dennoch sollten Betroffene die Täter bei der Polizei anzeigen, wenn nötig auch gegen unbekannt. Auch die Datenschutzbehörde kann ein Ansprechpartner sein.

Verbreitung einschränken

Da jede Verbreitung von Deepfakes die Rechte der Betroffenen erneut verletzt, sollten die Inhalte schnellstmöglich gelöscht und ihre Weiterverbreitung unterbunden werden. Theoretisch geht das am schnellsten über die Sozialen Netzwerke. Plattform-Anbieter wie Meta oder X sind „nach dem Telemedien- sowie dem Netzwerkdurchsetzungsgesetz verpflichtet, rechtsverletzende Inhalte zu prüfen und gegebenenfalls zu löschen. Auch gegen Google kann man vorgehen und verlangen, dass Verlinkungen auf andere Webseiten-Inhalte entfernt werden“, erklärt Solmecke. Ansonsten können Unterlassungsklagen und einstweilige Verfügungen die Verbreitung eindämmen.

In der Praxis ist es für Betroffene aber nahezu unmöglich, bereits verbreitete Inhalte vollständig zu löschen. In der Folge müssen Betroffene damit leben, dass Deepfake Pornografie von ihnen weiterhin zirkuliert und jederzeit wieder in ihr Leben treten kann. Die psychischen Belastungen, sozialen und auch wirtschaftlichen Konsequenzen auf dem Arbeitsmarkt sind für die Betroffenen enorm.

Apple entfernt „Nudify“-Apps aus dem App Store

Suchmaschinen unternehmen kaum etwas gegen gefälschte Promi-Nacktbilder

Taylor Swift Opfer von pornografischen Deepfakes – so reagiert X

Das fordern Verbände und Organisationen

Akteure wie der Deutsche Juristinnenbund und auch das Landesmedienzentrum Baden-Württemberg fordern ein generelles Verbot, neutrales Bildmaterial ohne Zustimmung zu Deepfakes zu verarbeiten und weiterzuverbreiten. HateAid verfolgt in der Petition an Volker Wissing ein ähnliches Ziel und fordert ein grundsätzliches Verbot von Diensten wie „Nudify“-Apps. Außerdem sieht HateAid die Betreiber der App-Stores in der Pflicht, „Nudify“-Apps zu sperren. Zusätzlich müsse es mehr staatlich geförderte Aufklärungs- und Beratungsangebote geben. Josephine Ballon sagt dazu gegenüber TECHBOOK: „Jedenfalls kann die Verantwortung für Unterstützung nicht allein bei privaten zivilgesellschaftlichen Organisationen liegen. Es müssen auch die Plattformen und Apps und mittlerweile auch KI-Bildgeneratoren zur Verantwortung gezogen werden.“

Die Bundesregierung erarbeitet zur Zeit ein Digitales Gewaltschutzgesetz, das Betroffenen bessere Möglichkeiten gibt, sich gegen digitale Gewalt zu wehren. Das Eckpunktepapier sieht einen erweiterten Auskunftsanspruch, einen Anspruch auf eine richterlich angeordnete Accountsperre sowie eine erleichterte Zustellung von Schreiben an Dienstanbieter wie Meta vor. HateAid begrüßt das Eckpunktepapier grundsätzlich, kritisiert aber, dass es nicht weit genug gehe. Vor allem die richterlich angeordnete Sperrung von Täterkonten sei kein massentaugliches Verfahren. Zumal man sich leicht neue Accounts erstellen kann. Der Gesetzgeber und auch die Polizei werden sich auf das erhöhte Aufkommen von Deepfake Pornos vorbereiten müssen